Tutte le sessioni di Transform 2021 sono ora disponibili on-demand. Guarda ora.

Questo articolo fa parte delle nostre recensioni dei documenti di ricerca sull'intelligenza artificiale, una serie di post che esplorano le ultime scoperte nel campo dell'intelligenza artificiale.

Una delle sfide principali dei modelli di apprendimento per rinforzo profondo – il tipo di sistemi di intelligenza artificiale che hanno padroneggiato Go, StarCraft 2 e altri giochi – è la loro incapacità di generalizzare le proprie capacità oltre il loro dominio di addestramento. Questo limite rende molto difficile applicare questi sistemi alle impostazioni del mondo reale, dove le situazioni sono molto più complicate e imprevedibili rispetto agli ambienti in cui vengono addestrati i modelli di intelligenza artificiale.

Ma gli scienziati del laboratorio di ricerca sull'intelligenza artificiale DeepMind affermano di aver compiuto "i primi passi per addestrare un agente in grado di giocare a molti giochi diversi senza bisogno di dati sull'interazione umana", secondo un post sul blog sulla loro nuova iniziativa di "apprendimento aperto". Il loro nuovo progetto include un ambiente 3D con dinamiche realistiche e agenti di apprendimento per rinforzo profondo che possono imparare a risolvere una vasta gamma di sfide.

Il nuovo sistema, secondo i ricercatori AI di DeepMind, è un "passo importante verso la creazione di agenti più generali con la flessibilità di adattarsi rapidamente in ambienti in costante cambiamento".

I risultati del documento mostrano alcuni notevoli progressi nell'applicazione dell'apprendimento per rinforzo a problemi complicati. Ma sono anche un promemoria di quanto i sistemi attuali siano lontani dal raggiungere il tipo di capacità di intelligence generale che la comunità dell'IA desiderava da decenni.

Contents

La fragilità dell'apprendimento per rinforzo profondo

Il vantaggio principale dell'apprendimento per rinforzo è la sua capacità di sviluppare comportamenti intraprendendo azioni e ottenendo feedback, in modo simile al modo in cui gli esseri umani e gli animali apprendono interagendo con il loro ambiente. Alcuni scienziati descrivono l'apprendimento per rinforzo come "la prima teoria computazionale dell'intelligenza".

La combinazione di apprendimento per rinforzo e reti neurali profonde, nota come apprendimento per rinforzo profondo, è stata al centro di molti progressi nell'intelligenza artificiale, inclusi i famosi modelli AlphaGo e AlphaStar di DeepMind. In entrambi i casi, i sistemi di intelligenza artificiale sono stati in grado di superare i campioni del mondo umani nei rispettivi giochi.

Ma i sistemi di apprendimento per rinforzo sono anche notoriamente rinomati per la loro mancanza di flessibilità. Ad esempio, un modello di apprendimento per rinforzo che può giocare a StarCraft 2 a livello esperto non sarà in grado di giocare a un gioco con meccaniche simili (ad esempio, Warcraft 3) a nessun livello di competenza. Anche lievi modifiche al gioco originale ridurranno notevolmente le prestazioni del modello AI.

"Questi agenti sono spesso costretti a giocare solo le partite per cui sono stati addestrati, mentre l'esatta istanziazione del gioco può variare (ad esempio il layout, le condizioni iniziali, gli avversari) gli obiettivi che gli agenti devono soddisfare rimangono gli stessi tra allenamento e test. La deviazione da questo può portare a un fallimento catastrofico dell'agente ", scrivono i ricercatori di DeepMind in un documento che fornisce tutti i dettagli sul loro apprendimento a tempo indeterminato.

Gli esseri umani, d'altra parte, sono molto bravi a trasferire la conoscenza attraverso i domini.

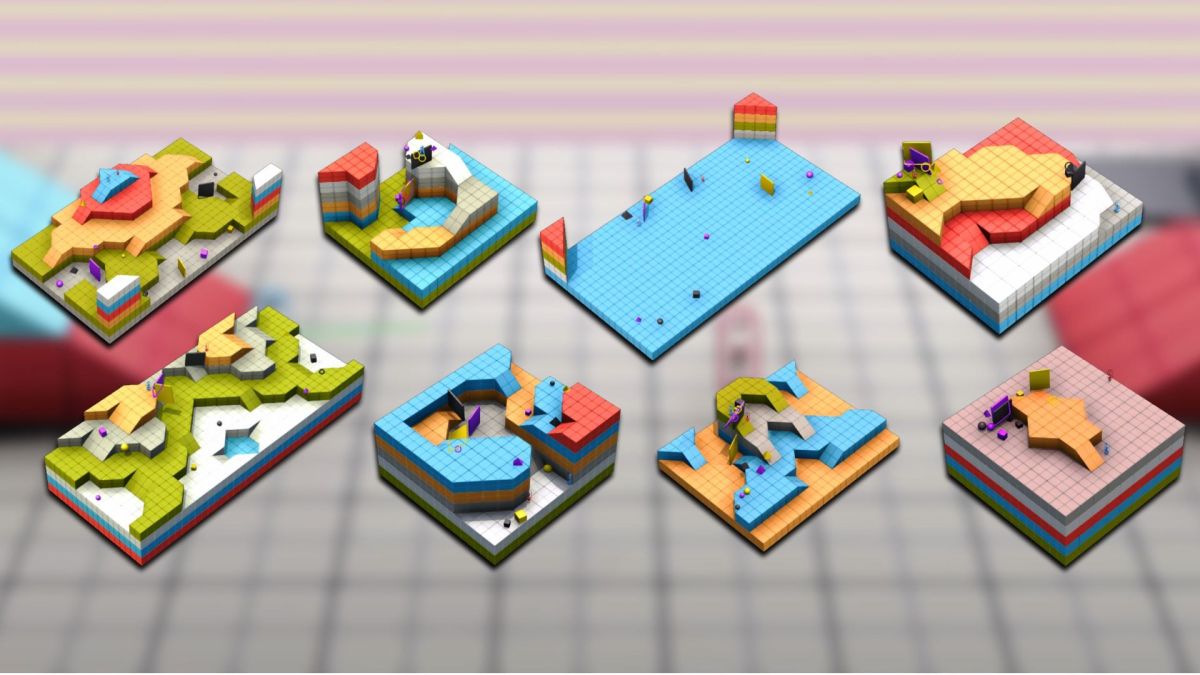

L'ambiente XLand

L'obiettivo del nuovo progetto di DeepMind era creare "un agente artificiale il cui comportamento si generalizza oltre il set di giochi su cui è stato addestrato".

A tal fine, il team ha creato XLand, un motore in grado di generare ambienti 3D composti da topologia statica e oggetti mobili. Il motore di gioco simula la fisica del corpo rigido e consente ai giocatori di utilizzare gli oggetti in vari modi (ad esempio, creare rampe, bloccare percorsi, ecc.).

XLand è un ambiente ricco in cui puoi addestrare gli agenti su un numero virtualmente illimitato di attività. Uno dei principali vantaggi di XLand è la capacità di utilizzare regole programmatiche per generare automaticamente una vasta gamma di ambienti e sfide per addestrare gli agenti di intelligenza artificiale. Questo risolve una delle sfide chiave dei sistemi di apprendimento automatico, che spesso richiedono grandi quantità di dati di addestramento curati manualmente.

Secondo il post sul blog, i ricercatori hanno creato "miliardi di attività in XLand, attraverso vari giochi, mondi e giocatori". I giochi includono obiettivi molto semplici come trovare oggetti in ambientazioni più complesse in cui gli agenti dell'IA pesano molto sui vantaggi e sui compromessi delle diverse ricompense. Alcuni dei giochi includono elementi di cooperazione o competizione che coinvolgono più agenti.

Apprendimento per rinforzo profondo

DeepMind utilizza l'apprendimento per rinforzo profondo e alcuni trucchi intelligenti per creare agenti di intelligenza artificiale che possono prosperare nell'ambiente XLand.

Il modello di apprendimento per rinforzo di ogni agente riceve una visione in prima persona del mondo, lo stato fisico dell'agente (ad esempio, se tiene un oggetto) e il suo obiettivo attuale. Ogni agente perfeziona i parametri della sua rete neurale politica per massimizzare i suoi premi sull'attività corrente. L'architettura della rete neurale contiene un meccanismo di attenzione per garantire che l'agente possa bilanciare l'ottimizzazione per gli obiettivi secondari necessari per raggiungere l'obiettivo principale.

Una volta che l'agente ha superato la sfida attuale, il generatore di attività computazionali crea una nuova sfida per l'agente. Ogni nuova attività viene generata in base alla cronologia della formazione dell'agente e in modo da aiutare a distribuire le competenze dell'agente in una vasta gamma di sfide.

DeepMind ha anche utilizzato le sue vaste risorse computazionali (per gentile concessione del suo proprietario Alphabet Inc.) per addestrare un'ampia popolazione di agenti in parallelo e trasferire i parametri appresi tra diversi agenti per migliorare le capacità generali dei sistemi di apprendimento per rinforzo.

DeepMind utilizza un meccanismo multi-step e basato sulla popolazione per addestrare molti agenti di apprendimento per rinforzo

Le prestazioni degli agenti di apprendimento per rinforzo sono state valutate in base alla loro capacità generale di svolgere un'ampia gamma di compiti su cui non erano stati formati. Alcune delle attività di test includono sfide ben note come "cattura la bandiera" e "nascondino".

Secondo DeepMind, ogni agente ha giocato a circa 700.000 giochi unici in 4.000 mondi unici all'interno di XLand e ha attraversato 200 miliardi di passaggi di allenamento in 3,4 milioni di compiti unici (nel documento, i ricercatori scrivono che 100 milioni di passaggi equivalgono a circa 30 minuti di allenamento) .

"In questo momento, i nostri agenti sono stati in grado di partecipare a ogni attività di valutazione generata proceduralmente, tranne una manciata che era impossibile anche per un essere umano", hanno scritto i ricercatori di intelligenza artificiale. "E i risultati che stiamo vedendo mostrano chiaramente un comportamento generale e zero-shot in tutto lo spazio delle attività".

I modelli di machine learning zero possono risolvere problemi che non erano presenti nel set di dati di addestramento. In uno spazio complicato come XLand, l'apprendimento zero-shot potrebbe implicare che gli agenti abbiano ottenuto una conoscenza fondamentale del loro ambiente invece di memorizzare sequenze di frame di immagini in compiti e ambienti specifici.

Gli agenti di apprendimento per rinforzo hanno ulteriormente manifestato segni di apprendimento generalizzato quando i ricercatori hanno cercato di adattarli a nuovi compiti. Secondo le loro scoperte, 30 minuti di messa a punto su nuove attività sono stati sufficienti per creare un notevole miglioramento in un agente di apprendimento per rinforzo addestrato con il nuovo metodo. Al contrario, un agente addestrato da zero per la stessa quantità di tempo avrebbe prestazioni prossime allo zero nella maggior parte delle attività.

Comportamento di alto livello

Secondo DeepMind, gli agenti di apprendimento per rinforzo mostrano l'emergere di "comportamenti euristici" come l'uso di strumenti, il lavoro di squadra e la pianificazione a più fasi. Se dimostrato, questo può essere un traguardo importante. I sistemi di deep learning sono spesso criticati per l'apprendimento di correlazioni statistiche invece di relazioni causali. Se le reti neurali potessero sviluppare nozioni di alto livello come l'utilizzo di oggetti per creare rampe o causare occlusioni, potrebbe avere un grande impatto su campi come la robotica e le auto a guida autonoma, dove il deep learning è attualmente in difficoltà.

Ma questi sono grandi se e i ricercatori di DeepMind sono cauti nel trarre conclusioni affrettate sulle loro scoperte. "Data la natura dell'ambiente, è difficile individuare l'intenzionalità: i comportamenti che vediamo spesso sembrano essere accidentali, ma li vediamo comunque verificarsi in modo coerente", hanno scritto nel loro post sul blog.

Ma sono fiduciosi che i loro agenti di apprendimento per rinforzo "sono consapevoli delle basi dei loro corpi e del passare del tempo e che capiscono la struttura di alto livello dei giochi che incontrano".

Tali abilità fondamentali autoapprese sono un altro degli obiettivi molto ricercati della comunità dell'intelligenza artificiale.

Teorie dell'intelligenza

Alcuni dei migliori scienziati di DeepMind hanno pubblicato di recente un articolo in cui ipotizzano che una singola ricompensa e apprendimento per rinforzo siano sufficienti per raggiungere alla fine l'intelligenza artificiale generale (AGI). Secondo gli scienziati, un agente intelligente con i giusti incentivi può sviluppare tutti i tipi di capacità come la percezione e la comprensione del linguaggio naturale.

Sebbene il nuovo approccio di DeepMind richieda ancora la formazione di agenti di apprendimento per rinforzo su più ricompense ingegnerizzate, è in linea con la loro prospettiva generale di raggiungere l'AGI attraverso l'apprendimento per rinforzo.

"Ciò che DeepMind mostra con questo documento è che un singolo agente RL può sviluppare l'intelligenza per raggiungere molti obiettivi, piuttosto che uno solo", ha detto Chris Nicholson, CEO di Pathmind, a TechTalks. “E le abilità che acquisisce nel realizzare una cosa possono essere generalizzate ad altri obiettivi. È molto simile a come viene applicata l'intelligenza umana. Ad esempio, impariamo ad afferrare e manipolare oggetti, e questo è il fondamento per raggiungere obiettivi che vanno dal battere un martello al rifare il letto".

Nicholson ritiene anche che altri aspetti dei risultati del documento suggeriscano progressi verso l'intelligenza generale. “I genitori riconosceranno che l'esplorazione aperta è proprio il modo in cui i loro bambini imparano a muoversi nel mondo. Prendono qualcosa da un armadio e lo rimettono dentro. Si inventano i propri piccoli obiettivi, che possono sembrare privi di significato per gli adulti, e li padroneggiano ", ha detto. "DeepMind sta fissando in modo programmatico obiettivi per i suoi agenti in questo mondo e quegli agenti stanno imparando a padroneggiarli uno per uno".

Gli agenti di apprendimento per rinforzo hanno anche mostrato segni di sviluppo dell'intelligenza incarnata nel loro mondo virtuale, ha detto Nicholson, come il tipo che hanno gli umani. "Questa è un'ulteriore indicazione che l'ambiente ricco e malleabile in cui le persone imparano a muoversi e manipolare favorisce l'emergere dell'intelligenza generale e che le analogie biologiche e fisiche dell'intelligenza possono guidare ulteriori lavori nell'IA", ha affermato.

Sathyanaraya Raghavachary, Professore Associato di Informatica presso la University of Southern California, è un po' più scettico sulle affermazioni fatte nel documento di DeepMind, in particolare le conclusioni sulla propriocezione, la consapevolezza del tempo e la comprensione di alto livello di obiettivi e ambienti.

"Anche noi umani non siamo pienamente consapevoli dei nostri corpi, per non parlare di quegli agenti VR", ha detto Raghavachary nei commenti a TechTalks, aggiungendo che la percezione del corpo richiede un cervello integrato che è co-progettato per la consapevolezza del corpo e la collocazione nello spazio. “Lo stesso con il passare del tempo: anche questo richiederebbe un cervello che abbia memoria del passato e un senso per il tempo in relazione a quel passato. Ciò che loro (autori di articoli) potrebbero significare si riferisce al monitoraggio dei cambiamenti progressivi degli agenti nell'ambiente derivanti dalle loro azioni (ad esempio come risultato dello spostamento di una piramide viola), cambiamenti di stato che genererebbe il simulatore di fisica sottostante.

Raghavachary sottolinea inoltre che se gli agenti potessero comprendere la struttura di alto livello dei loro compiti, non avrebbero bisogno di 200 miliardi di passaggi di addestramento simulato per raggiungere risultati ottimali.

"L'architettura sottostante manca di ciò che serve, per raggiungere queste tre cose (consapevolezza del corpo, passaggio del tempo, comprensione della struttura del compito di alto livello) che sottolineano in conclusione", ha detto. "Nel complesso, XLand è semplicemente 'più o meno lo stesso.'"

Il divario tra simulazione e mondo reale

In poche parole, il documento dimostra che se riesci a creare un ambiente sufficientemente complesso, progettare la giusta architettura di apprendimento per rinforzo ed esporre i tuoi modelli a un'esperienza sufficiente (e hai molti soldi da spendere in risorse di calcolo), sarai in grado generalizzare a vari tipi di compiti nello stesso ambiente. E questo è fondamentalmente il modo in cui l'evoluzione naturale ha fornito l'intelligenza umana e animale.

In effetti, DeepMind ha già fatto qualcosa di simile con AlphaZero, un modello di apprendimento per rinforzo che è riuscito a padroneggiare più giochi a turni per due giocatori. L'esperimento XLand ha esteso la stessa nozione a un livello molto più grande aggiungendo l'elemento di apprendimento zero-shot.

Ma mentre penso che l'esperienza degli agenti formati da XLand sarà alla fine trasferibile ad applicazioni del mondo reale come la robotica e le auto a guida autonoma, non penso che sarà una svolta. Dovrai comunque scendere a compromessi (come creare limiti artificiali per ridurre la complessità del mondo reale) o creare miglioramenti artificiali (come impregnare i modelli di apprendimento automatico con conoscenze pregresse o sensori aggiuntivi).

Gli agenti di apprendimento per rinforzo di DeepMind potrebbero essere diventati i padroni di XLand virtuale. Ma il loro mondo simulato non ha nemmeno una frazione delle complessità del mondo reale. Questo divario continuerà a rappresentare una sfida per molto tempo.

Ben Dickson è un ingegnere del software e il fondatore di TechTalks. Scrive di tecnologia, affari e politica.

Questa storia è apparsa originariamente su Bdtechtalks.com. Copyright 2021

VentureBeat

La missione di VentureBeat è quella di essere una piazza cittadina digitale per i responsabili delle decisioni tecniche per acquisire conoscenze sulla tecnologia trasformativa e sulle transazioni.

Il nostro sito fornisce informazioni essenziali sulle tecnologie e sulle strategie dei dati per guidarti nella guida delle tue organizzazioni. Ti invitiamo a diventare un membro della nostra community, per accedere a:

- informazioni aggiornate sugli argomenti di tuo interesse

- le nostre newsletter

- contenuti gated leader di pensiero e accesso scontato ai nostri eventi preziosi, come Trasforma 2021: Per saperne di più

- funzioni di rete e altro

Diventare socio